在当今数字化驱动的时代,数据处理服务已成为企业技术栈中的核心支柱。Uber作为全球出行服务的巨头,其基于微服务的庞大架构和高效的数据处理系统,为我们提供了极具参考价值的实战范本。深入剖析Uber的实践,我们可以提炼出一套炼成数据处理服务最佳实践的方法论。

一、 核心原则:解耦、弹性与可观测性

Uber微服务架构的成功,首先根植于几个核心原则。对于数据处理服务而言,这意味着:

- 服务解耦与单一职责:每个数据处理服务应专注于一个明确的业务领域或数据流程(如行程计价、ETA计算、欺诈检测)。这降低了系统复杂性,便于独立开发、部署和扩展。

- 弹性设计:面对全球规模的实时数据流,服务必须具备容错和自愈能力。Uber广泛采用断路器、重试、降级和背压机制,确保局部故障不会引发系统性雪崩。

- 深度可观测性:通过全面的指标(Metrics)、链路追踪(Tracing)和日志(Logging)体系,实现从数据接入、处理到输出的全链路透明化。这是保障服务SLA、快速定位问题的基石。

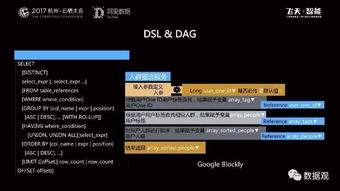

二、 架构模式:流批一体与事件驱动

Uber的数据处理架构演化体现了现代趋势:

- 流批一体的数据处理:早期Lambda架构的复杂性催生了Kappa架构的普及。Uber利用Apache Flink等流处理引擎,构建了统一的实时与近实时数据处理管道,简化了技术栈,并保证了数据在流与批处理间的一致性。

- 事件驱动的数据流转:核心业务状态变更通过事件(如

TripStarted,PaymentCompleted)发布到消息队列(如Kafka)。数据处理服务作为消费者订阅这些事件,实现异步、松耦合的数据处理与分析,提升了系统的整体响应性和扩展性。

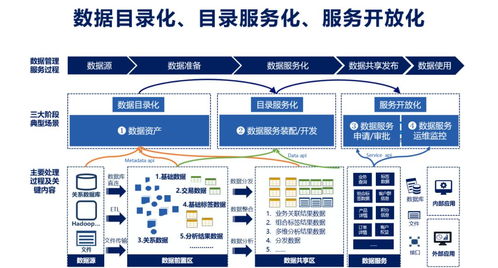

三、 数据治理与质量保障

大规模数据处理中,数据质量是生命线。Uber的最佳实践包括:

- Schema管理与契约:严格定义和治理数据Schema(如使用Protobuf、Avro),确保服务间数据接口的稳定性和向前/向后兼容性,减少“数据泥潭”。

- 数据血缘与沿袭:构建自动化的数据血缘图,清晰追踪数据从源头到消费端的完整路径。这对于影响分析、故障排查和合规审计至关重要。

- 端到端的质量监控:在关键数据流水线中嵌入数据质量检查点,监控数据的完整性、准确性、及时性和一致性,并设置自动告警。

四、 工程与运维实践

最佳实践的落地离不开扎实的工程文化与工具支撑:

- 自动化与GitOps:数据处理作业的部署、配置管理与扩缩容应完全自动化。Uber推崇的“Pipelines as Code”和GitOps模型,将基础设施和流水线定义纳入版本控制,确保了环境的一致性和可重复性。

- 混沌工程与韧性测试:主动在生产环境中模拟数据中心故障、网络延迟、依赖服务中断等场景,持续验证数据处理服务的韧性,避免“黑天鹅”事件。

- 成本感知与效率优化:对数据处理作业进行持续的性能剖析和资源使用效率评估,通过优化计算逻辑、调整资源分配、采用分层存储等手段,在性能与成本间取得最佳平衡。

五、 组织与文化:数据网格的雏形

Uber的实践也暗合了“数据网格”的理念。他们将数据视为产品,鼓励领域团队(如出行、外卖)拥有并维护其领域内的数据产品(包括数据处理服务)。这促进了数据所有权明确、领域专家深度参与,使数据处理更贴近业务需求,加速了价值交付。

****

从Uber的微服务架构中学习数据处理服务的最佳实践,我们看到这并非一蹴而就,而是一个融合了清晰架构原则、先进技术模式、严格治理标准、卓越工程实践以及敏捷组织文化的持续炼成过程。其精髓在于:以服务化思维构建弹性的数据管道,以产品化思维保障数据质量与价值,最终在规模、速度、可靠性与成本之间构建动态而稳固的平衡,为业务创新提供强大且可靠的数据驱动力。